« Mes amis étaient tous surpris par cet intérêt pour un produit si axé sur la vue. J'ai peut-être trop regardé de films de science-fiction quand j'étais petit, et je pensais que cela pourrait être génial ! » raconte Kévin, qui est aveugle, à propos de son envie de tester l'Apple Vision Pro. Aveugle, il l'est « totalement », a-t-il souligné dans son courriel lorsqu'il nous a contactés pour raconter son expérience de l'utilisation du casque. Un produit qui porte dans son nom et son usage le sens dont notre lecteur est privé.

Comme pour ses autres produits, Apple a doté le système d'exploitation du Vision Pro des fonctions d'accessibilité VoiceOver. Un effort salué pour ce produit orienté sur la vision, qui a permis à Kévin d'assouvir sa curiosité pour ce casque en participant aux démos proposées en Apple Store.

Diplômé en architecture logicielle, cet utilisateur a monté sa propre société, IEyes, qui développe du matériel adapté aux personnes déficientes visuelles. Il travaille pour une large partie sur Windows pour ses développements — « Xcode avec VoiceOver est vraiment une usine à gaz », dit-il — mais il est aussi utilisateur des produits d'Apple et donc familier avec les fonctions d'accessibilité.

Les préparatifs pour cette démonstration ont été rapides — pas de lunettes, pas de lentilles… — avec des conseillers en Apple Store d'abord « surpris » par son intérêt pour ce casque. Mais ils ont prolongé la demi-heure prévue, car certaines étapes se sont avérées plus longues que prévu :

On m'explique qu'avant de le mettre, il faut prendre des mesures de mon visage à l'aide d'un iPhone. Très bien, j'avais tenté l'expérience la veille chez moi avec l'app Apple Store, sans succès. Après quelques tentatives, nous n'avons pas réussi non plus sur place. On m'a aidé à cadrer ma tête, mon regard, etc., mais ça n'a pas fonctionné.

J'ai donc invité mon conseiller à le faire pour moi avec son visage, car la démo nécessite vraiment cette étape. Si nos visages sont trop différents en taille, il y a un risque d'avoir des fuites de lumière dans le casque, ce qui pourrait dégrader l'expérience. À ce niveau-là, je n'étais pas inquiet.

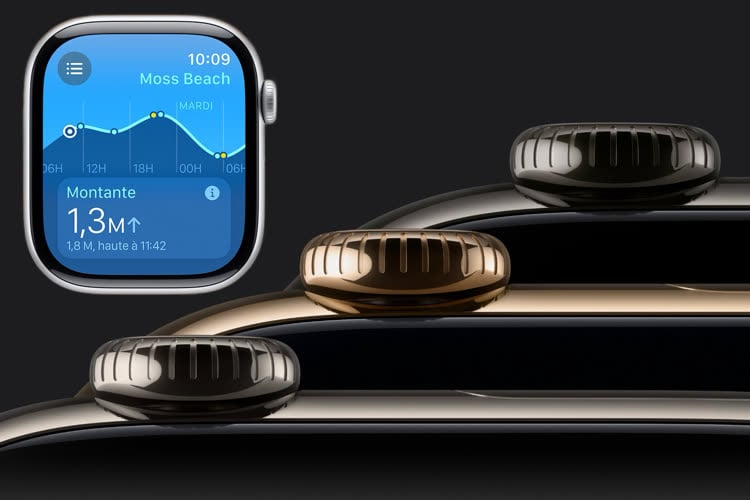

Puis c'est le grand bain de visionOS avec un casque « vraiment lourd » sur la tête. Trois pressions sur le bouton de gauche activent ensuite VoiceOver et l'une des voix d'assistance résonne dans les écouteurs : « Le son est très clair et net et j'imagine que l'on peut entendre le lecteur d'écran si on se place à côté de moi ».

Les premiers instants sont encore laborieux du fait d'un mode de démonstration perfectible : « Nous avons rencontré pas mal de difficultés pour trouver les bonnes gestuelles sur le Vision Pro. Le site d'Apple répertorie bien tout cela, mais le mode de démonstration était capricieux. Après plusieurs essais, nous avons enfin réussi, et je suis en mesure de me déplacer dans le casque en utilisant l'une de mes mains ».

À quoi ressemble, pour un aveugle, l'utilisation d'un environnement spatial où des caméras suivent le regard afin de réagir aux mouvements des doigts et des mains ? Kévin tente une description :

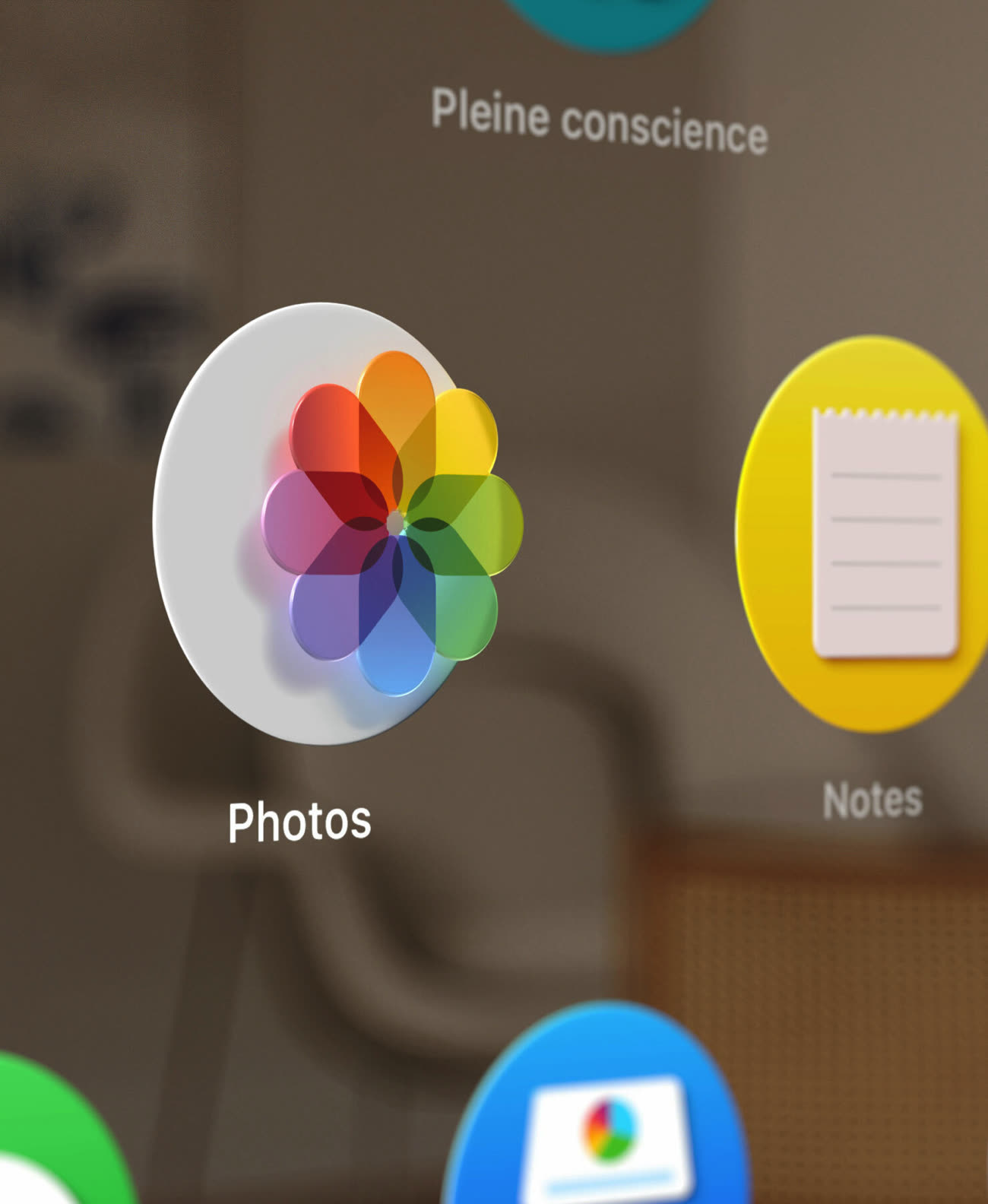

Un peu comme sur iOS, nous avons une vision à plat de la fenêtre. Prenons par exemple l'écran d'accueil : nous ne savons pas que c'est une grille, mais plutôt un enchaînement d'icônes.

Sur iOS, nous effectuons un balayage de droite à gauche pour accéder à l'élément précédent, et inversement pour l'élément suivant, puis un double tap pour valider l'objet en focus. C'est vraiment la base de chaque lecteur d'écran : le déplacement dans l'interface.

Avec le Vision Pro, nous utilisons notre main, placée dans le champ de vision des caméras de l'appareil, pour réaliser ces mêmes actions.

Cela donne la combinaison de geste et d'actions suivantes :

- Pincement pouce + index : déplacer le focus en avant (corresponds à un balayage de gauche à droite sur iOS).

- Pincement pouce + majeur : déplacer le focus en arrière (corresponds à un balayage de droite à gauche sur iOS).

- Pincement pouce + annulaire : valider l'élément qui a le focus (double tap sur iOS).

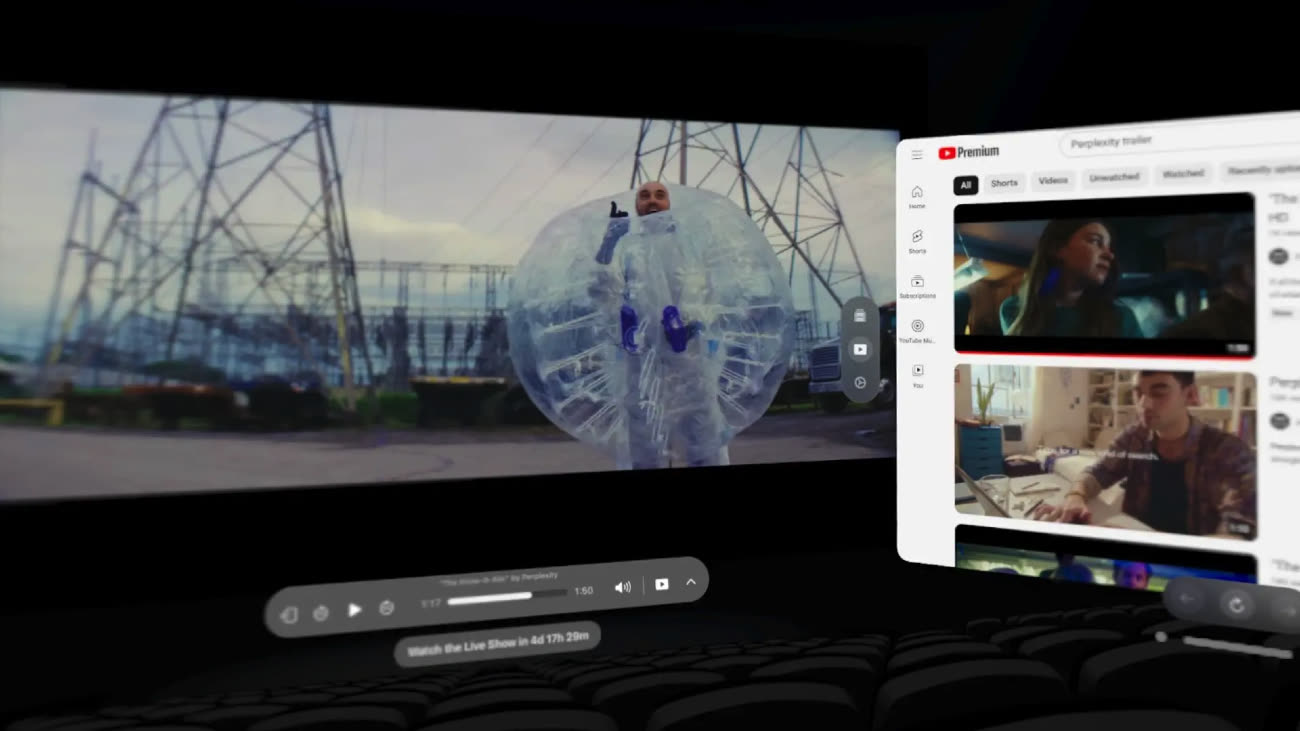

C'est très sommaire au niveau des gestes, dit-il, mais cette base lui a permis d'avancer dans la démonstration et de jouer avec les apps Apple TV, Musique, Keynote, Safari, Mail, Messages, etc.

C'est un peu bizarre de se déplacer avec des pincements de doigts, mais il faut reconnaître que ça marche bien. J'ai lancé le film Super Mario, écouté de la musique, ouvert une présentation Keynote et regardé les mails hyper secrets d'Apple…

La prise en main avec VoiceOver est bien moins fluide et intuitive que sur un appareil iOS/watchOS, mais je pense qu'avec le temps, on peut s'y habituer. Il sera peut-être compliqué de garder la main levée et orientée vers les caméras en permanence, voire fatigant.

Quand on passe en mode environnement (qui entoure l'utilisateur d'un paysage, NDLR), VoiceOver nous indique le nombre de visages en face de nous, mais il n'y a pas de description plus poussée que cela.

Ces gestes ont plutôt bien fonctionné, note Kevin qui admet cependant qu'il manque cette dimension tactile que l'on a sur d'autres appareils. Il n'y a pas non plus de retour haptique possible derrière une action que l'on effectue en agitant les doigts dans l'air : « Une gestuelle moins basée sur des mouvements dans l'air, par exemple en exécutant des balayages sur la table en face de soi serait moins frustrante. Cependant, cela limiterait l'utilisation du Vision Pro à un type d'environnement spécifique ». C'est peut-être une question d'habitude, mais il est difficile de faire le tour de la question avec ces courtes démonstrations.

Cette mise en bouche qui a finalement duré une bonne heure a néanmoins donné quelques idées de scénarios, dans lesquels c'est le casque qui se chargerait de voir à la place de son utilisateur :

Mon rêve c'est un Vision Pro qui me décrit mon environnement grâce à Apple Intelligence et tout cela hors ligne. Mais je pense qu'il faudra être patient, et que Meta y parviendra certainement avant avec les lunettes Ray-Ban. Apple essaye toutefois d'innover là où personne n'avait essayé auparavant, et pour une version 1 c'est plutôt prometteur. Est-ce que des personnes aveugles vont vraiment acheter ce produit ? Je ne pense pas, pas dans l'état actuel. L'avenir nous le dira.

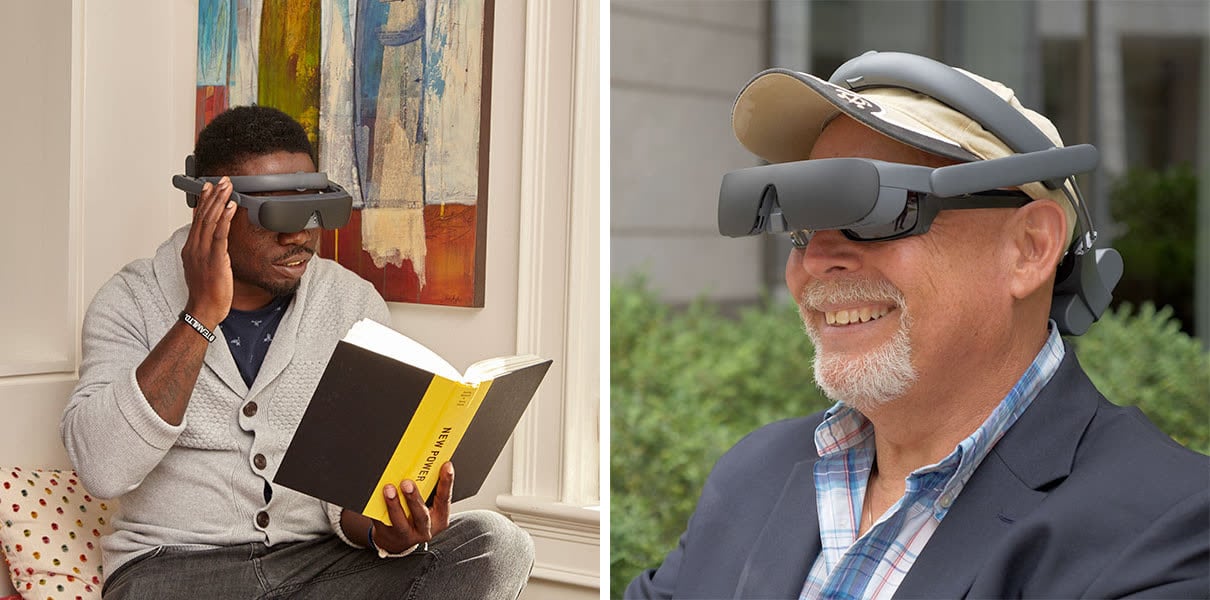

Pour des malvoyants il y a peut-être une carte à jouer, estime tout de même Kevin qui cite en exemple le casque eSight4. Vendu 6 500 €, il est destiné à augmenter l'environnement visuel de personnes dont l'acuité visuelle est extrêmement basse. Mais il n'offre pas tout l'environnement applicatif d'un Vision Pro. La suite ce sera visionOS 2, que notre lecteur a bien l'intention de tester à l'occasion des futures séances de démonstration en Apple Store.

Aperçu de visionOS 2 : Apple voit moins flou, mais pas encore très clair